Reglamento IA

Última actualización: 9/12/2024

¿Qué es la ley de IA?

El Reglamento europeo de IA de la UE es la primera ley integral en materia de inteligencia artificial del mundo. Su objetivo es mitigar el impacto negativo significativo de la IA en la salud, la seguridad y los derechos fundamentales. Con este reglamento, como ya ocurrió con el Reglamento de Protección de Datos, la Unión Europea se posiciona como líder mundial en derechos digitales, pero ahora en un nuevo ámbito: la inteligencia artificial

El Reglamento introduce un marco uniforme en todos los países de la UE, basado en una definición prospectiva de la inteligencia artificial y un enfoque basado en el riesgo, regulando los usos de la tecnología, pero no la tecnología en sí.

Este marco normativo se aplicará a los agentes tanto públicos como privados, de dentro y fuera de la UE, en la medida en que el sistema de inteligencia artificial se introduzca en el mercado de la Unión o su uso afecte a personas establecidas en ella.

No entran dentro del ámbito de aplicación de este Reglamento los sistemas de inteligencia artificial diseñados exclusivamente con fines militares, de defensa o de seguridad nacional, así como las actividades de investigación, desarrollo y de prototipos que tengan lugar antes de la comercialización de un sistema de inteligencia artificial.

¿A qué obliga el Reglamento y a quién afecta?

El Reglamento de IA establece:

- Normas armonizadas para la introducción en el mercado, la puesta en servicio y la utilización de sistemas de inteligencia artificial en la UE

- Prohibiciones de determinadas prácticas de IA en el entorno de la Unión.

- Requisitos específicos para los sistemas de IA de alto riesgo y obligaciones para los operadores de dichos sistemas.

- Normas armonizadas de transparencia aplicables a determinados sistemas de IA de riesgo limitado.

- Normas armonizadas para la introducción en el mercado de modelos de IA de uso general, bien sean de riesgo sistémico o no.

- Normas sobre el seguimiento del mercado, la vigilancia de mercado, la gobernanza y una serie de garantías de cumplimiento.

- Por primera vez, un reglamento europeo también introduce medidas de apoyo a la innovación, prestando especial atención a las pymes, incluidas las empresas emergentes o startups.

Será aplicable a:

- Los proveedores que introduzcan en el mercado o pongan en servicio sistemas de IA o modelos de IA de uso general en la UE, con independencia de si están o no establecidos en la UE o en un tercer estado.

- Los responsables del despliegue de sistemas de IA que estén establecidos o ubicados en la UE o cuando los resultados de salida generados por el sistema de IA se utilicen en la Unión.

- Los importadores y distribuidores de sistemas de IA.

- Los fabricantes de productos que introduzcan en el mercado o pongan en servicio un sistema de IA junto con su producto y con su propio nombre o marca.

- Los representantes autorizados de los proveedores que no estén establecidos en la Unión.

- Las personas afectadas que estén ubicadas en la Unión.

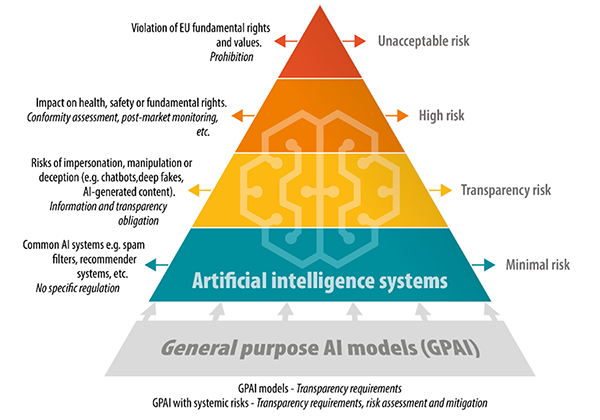

¿Qué niveles de riesgo establece el Reglamento?

El Reglamento establece unos niveles de riesgo en función del uso de la IA y, sobre las categorías detectadas, establece una serie de obligaciones.

Riesgo Inadmisible

El reglamento prohíbe algunos usos de los sistemas de IA porque suponen un riesgo inaceptable para la Unión. Se trata de un conjunto muy limitado de usos especialmente nocivos que se oponen a los valores de la UE porque vulneran los derechos fundamentales y afectan gravemente a la seguridad o a la salud de las personas. Estos usos son:

- Despliegue de técnicas subliminales, manipuladoras o engañosas para distorsionar el comportamiento y perjudicar la toma de decisiones con conocimiento de causa, causando un daño significativo.

- Explotar las vulnerabilidades relacionadas con la edad, la discapacidad o las circunstancias socioeconómicas para distorsionar el comportamiento, causando daños significativos.

- Sistemas de categorización biométrica que infieran atributos sensibles (raza, opiniones políticas, afiliación sindical, creencias religiosas o filosóficas, vida sexual u orientación sexual), excepto el etiquetado o filtrado de conjuntos de datos biométricos adquiridos legalmente o cuando las fuerzas de seguridad categoricen datos biométricos.

- Puntuación social, es decir, evaluar o clasificar a individuos o grupos basándose en comportamientos sociales o rasgos personales, causando un trato perjudicial o desfavorable a esas personas.

- Evaluar el riesgo de que un individuo cometa delitos penales basándose únicamente en perfiles o rasgos de personalidad, excepto cuando se utilice para aumentar las evaluaciones humanas basadas en hechos objetivos y verificables directamente relacionados con la actividad delictiva.

- Compilación de bases de datos de reconocimiento facial mediante el raspado no selectivo de imágenes faciales de Internet o de grabaciones de CCTV.

- Inferir emociones en lugares de trabajo o centros educativos, salvo por razones médicas o de seguridad.

- Identificación biométrica remota "en tiempo real" en espacios públicos para las fuerzas de seguridad excepto en:

- búsqueda de personas desaparecidas, víctimas de secuestros y personas víctimas de la trata de seres humanos o la explotación sexual;

- prevenir una amenaza sustancial e inminente para la vida, o un ataque terrorista previsible; o

- identificar a sospechosos de delitos graves (por ejemplo, asesinato, violación, robo a mano armada, tráfico de estupefacientes y armas ilegales, delincuencia organizada y delitos contra el medio ambiente, etc.).

La Comisión publicará directrices sobre las prohibiciones antes de su entrada en vigor el 2 de febrero de 2025.

Alto Riesgo

La mayor parte del Reglamento está enfocado a regular los sistemas de IA de alto riesgo, también conocidos por como HRAIS (High Risk AI Systems), que pueden suponer un perjuicio para la salud, la seguridad o los derechos fundamentales de las personas, contenidos en la Carta de los Derechos Fundamentales de la UE. Se dividen en dos categorías:

- Los componentes de seguridad de los productos contemplados en la legislación sectorial de la Unión cuando estén sujetos a una evaluación de la conformidad por terceros con arreglo a esa legislación sectorial, recogidos en el anexo I del Reglamento de IA.

- Los sistemas de IA pertenecientes a ocho ámbitos específicos, recogidos en el anexo III del Reglamento de IA, que son:

- Biometría no prohibida: Sistemas de identificación biométrica a distancia, excluida la verificación biométrica que confirma que una persona es dice ser. Sistemas de categorización biométrica que infieren atributos o características sensibles o protegidos. Sistemas de reconocimiento de emociones.

- Infraestructuras críticas: Componentes de seguridad en la gestión y explotación de infraestructuras digitales críticas, tráfico rodado y suministro de agua, gas, calefacción y electricidad.

- Educación y formación profesional: Sistemas de IA que determinan el acceso, la admisión o la asignación a instituciones educativas y de formación a profesionales a todos los niveles. Evaluación de los resultados del aprendizaje, incluidos los utilizados para dirigir el proceso de aprendizaje del alumno. Evaluar el nivel de educación adecuado para un individuo. Supervisión y detección de comportamientos prohibidos de los alumnos durante los exámenes.

- Empleo, gestión de trabajadores y acceso al autoempleo: Sistemas de IA utilizados para el reclutamiento o la selección, en particular anuncios de empleo específicos, análisis y filtrado de solicitudes, y evaluación de candidatos. Promoción y rescisión de contratos, asignación de tareas en función de rasgos de personalidad o características y comportamiento, y seguimiento y evaluación del rendimiento.

- Acceso y disfrute de servicios públicos y privados esenciales: Sistemas de IA utilizados por las autoridades públicas para evaluar el derecho a prestaciones y servicios, incluida su asignación, reducción, revocación o recuperación. Evaluación de la solvencia, excepto para detectar fraudes financieros. Evaluación y clasificación de llamadas de emergencia, incluida la priorización de envíos de la policía, los bomberos, la asistencia médica y los servicios de triaje de pacientes urgentes. Evaluación de riesgos y tarificación de seguros de salud y de vida.

- Aplicación de la ley: Sistemas de IA utilizados para evaluar el riesgo de una persona de convertirse en víctima de un delito. Polígrafos. Evaluación de la fiabilidad de las pruebas durante investigaciones o procesos penales. Evaluación del riesgo de delincuencia o reincidencia de una persona no basada únicamente en la elaboración de perfiles o en la evaluación de rasgos de personalidad o comportamientos delictivos anteriores. Elaboración de perfiles durante detecciones, investigaciones o enjuiciamientos penales.

- Gestión de la migración, el asilo y el control fronterizo: Polígrafos. Evaluaciones de migración irregular o riesgos sanitarios. Examen de solicitudes de asilo, visados y permisos de residencia, y reclamaciones relacionadas con la admisibilidad. Detección, reconocimiento o identificación de personas, excepto verificación de documentos de viaje.

- Actividad jurisdiccional y procesos democráticos: Sistemas de IA utilizados en la investigación e interpretación de hechos y en la aplicación de la ley a hechos concretos o utilizados en la resolución alternativa de conflictos. Influencia en los resultados de elecciones y referendos o en el comportamiento electoral, excluidos los productos que no interactúan directamente con las personas, como las herramientas utilizadas para organizar, optimizar y estructurar campañas políticas.

Los sistemas de alto riesgo han de cumplir determinados requisitos y se imponen obligaciones específicas tanto a los proveedores como a los responsables de despliegue de los sistemas.

Riesgo Limitado (Especifico de Transparencia)

Para determinados sistemas de inteligencia artificial, como cuando exista riesgo claro de manipulación, por ejemplo, mediante el uso de robots conversacionales) o ultrafalsificación, el Reglamento de IA establece obligaciones específicas de transparencia para que los usuarios sean conscientes de que están interactuando con una máquina.

Riesgo Mínimo

La mayoría de los demás sistemas de inteligencia artificial pueden programarse y utilizarse con arreglo a la legislación vigente, sin obligaciones jurídicas adicionales. De forma voluntaria, los proveedores de estos sistemas pueden optar por aplicar los requisitos de una inteligencia artificial voluntariamente y adherirse a códigos de conducta facultativos. Ejemplos de ellos son aplicaciones de IA en videojuegos, o filtros de spam para el correo electrónico.

¿Cuáles son los requisitos para los sistemas de alto riesgo?

El Reglamento impone una serie de obligaciones que los sistemas de IA de alto riesgo deben cumplir:

- Sistema de Gestión de Riesgos

El proveedor de un sistema de IA de alto riesgo deberá establecer, aplicar, documentar y mantener un sistema de gestión de riesgos. Se identificarán y valorarán amenazas, se adoptarán medidas de mitigación, y se monitorizarán sus efectos, en un ciclo de mejora continua que se prolongará durante todo el ciclo de vida del sistema.

- Datos y Gobernanza de Datos

Los sistemas de IA de alto riesgo que utilizan técnicas de entrenamiento de modelos con datos se desarrollarán a partir de conjuntos de datos de entrenamiento, validación y prueba que se someterán a prácticas adecuadas de gobernanza y gestión de datos. Entre estas prácticas destacan:

- Elegir un diseño adecuado.

- Adoptar los procesos adecuados de recopilación de datos.

- Operaciones de tratamiento de datos oportunas, como anotación, etiquetado, depuración, enriquecimiento y agregación.

- Análisis y depuración de los posibles sesgos.

- Evaluación previa de disponibilidad, cantidad y adecuación de los datasets necesarios.

-

Documentación Técnica

Los proveedores deben suministrar a los usuarios y a las autoridades documentación técnica del sistema de IA. La documentación demostrará que se cumplen los requisitos del Reglamento que estamos comentando, y explicará cómo comprobarlo. El AIA describe la información mínima que deberá proveer un sistema de IA.

- Registros

Los sistemas generarán permanentemente registros, o logs, que tienen que garantizar un nivel de trazabilidad de su funcionamiento adecuado para su finalidad prevista.

Además, durante toda la vida del sistema, se recogerán y analizarán evidencias para asegurar que el sistema funciona normalmente y cumple las disposiciones del Reglamento, a través de un proceso continuo de monitorización post-comercialización.

-

Transparencia y Comunicación de Información a los Usuarios

Los sistemas deben diseñarse de una forma que se garantice a los usuarios un funcionamiento suficientemente transparente, es decir, que les permita comprenderlo y utilizarlo adecuadamente. Con el sistema, el proveedor tendrá que proporcionar instrucciones de uso con información concisa, completa, correcta y clara que sea pertinente, accesible y comprensible para los usuarios.

-

Vigilancia Humana

Los sistemas se diseñarán y desarrollarán de forma que su uso pueda ser supervisado por personas físicas. Esta vigilancia debe prevenir o minimizar los riesgos para la salud, la seguridad o los derechos fundamentales que pueden surgir tanto si el HRAIS se utiliza conforme a su finalidad prevista como si se le da un uso indebido razonablemente previsible, en particular cuando dichos riesgos persisten a pesar de aplicar los demás requisitos.

-

Precisión, Solidez y Ciberseguridad

Los sistemas de IA de alto riesgo se diseñarán, desarrollarán y mantendrán de forma que alcancen, según su finalidad prevista, un nivel adecuado de precisión de los resultados. Las instrucciones de uso que los acompañarán indicarán los niveles de precisión y los parámetros de precisión pertinentes.

Los sistemas deberán ofrecer un grado adecuado de resiliencia ante las limitaciones en los sistemas o en el entorno en el que estos funcionan (p. ej., errores, fallos, incoherencias o situaciones inesperadas.

Los sistemas han de diseñarse de forma que sean resistentes a los intentos de terceros de aprovechar las vulnerabilidades del sistema, en particular de las vulnerabilidades específicas de los sistemas de IA, como pueden ser la corrupción intencionada de los datos de entrenamiento para manipular las salidas que producen.

Proceso de Cumplimiento

Previo a la comercialización de un sistema de inteligencia artificial de alto riesgo en el mercado de la UE, los proveedores deberán someterlo a una evaluación de conformidad o de manera alternativa a una autoevaluación. Esto les permitirá demostrar que su sistema cumple con los requisitos obligados de una inteligencia artificial de confianza. Adicionalmente también deben de cumplir con las siguientes obligaciones:

- Contar con un sistema de gestión de calidad

- Mantener la documentación del sistema

- Custodiar los registros de actividad

- Colaborar con las autoridades demostrando cumplimiento, y notificando incumplimientos y riesgos detectados.

Las obligaciones de los usuarios (responsables del despliegue según la nomenclatura del Reglamento) son: supervisión humana, monitorizar los sistemas, guardar registros y colaborar con las autoridades.

Las obligaciones de Importadores y distribuidores son: conservar la documentación técnica, asegurar que los productos han superado la evaluación de conformidad, y colaborar con las autoridades.

¿Cuándo es de obligado cumplimiento el Reglamento?

El 2 de agosto del 2024 entró en vigor el Reglamento europeo de IA, 20 días después de su publicación en el Diario Oficial de la Unión Europea. El Reglamento será de aplicación dos años después de su entrada en vigor, es decir, el 2 de agosto de 2026, con excepción de las disposiciones específicas siguientes:

- Serán aplicable a partir del 2 de febrero de 2025 las disposiciones generales (capítulo I del Reglamento) y las prácticas de IA prohibidas (capítulo II del Reglamento).

- Serán aplicables a partir del 2 de agosto del 2025:

- Organismos notificados (capítulo III, sección 4 del Reglamento)

- Modelos GPAI (capítulo V del Reglamento)

- Gobernanza (capítulo VII del Reglamento)

- Confidencialidad (artículo 78 del Reglamento)

- Sanciones (artículos 99 y 100 del Reglamento)

- El 2 de agosto del 2027 comienzan a aplicarse las obligaciones para los sistemas de IA de alto riesgo integrados en productos regulados por la legislación harmonizada de la Unión (artículo 6.1 del Reglamento).